Carol morreu nos quadrinhos de The Walking Dead de forma surpreendente

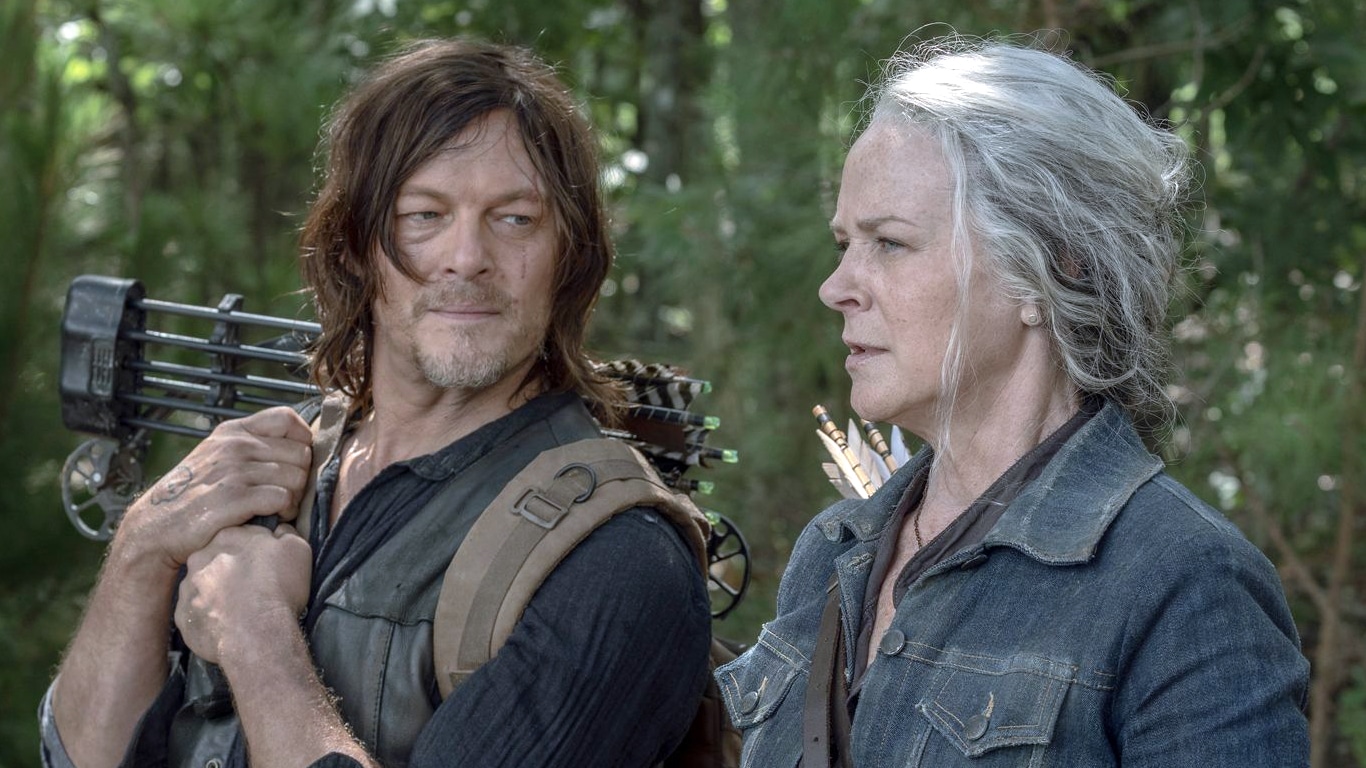

Enquanto a Carol da série The Walking Dead permanece viva, sua versão dos quadrinhos não sobreviveu. A produção está em sua 11ª e última temporada, com os últimos episódios sendo disponibilizados exclusivamente pelo Star+ no Brasil e deve ser finalizada em 2022. A personagem de Melissa McBride, no entanto, não só continua na série até …